Mikrotargetowanie, sukces przedsiębiorstwa i wygrana Trupma w wyborach – jaki jest ich wspólny mianownik?

Przekonanie o tym, że jeden komunikat reklamowy może trafić do masowego odbiorcy, odchodzi do lamusa. Za znacznie skuteczniejsze uważa się precyzyjne określanie mikro grupy docelowej i formułowanie przekazu, który trafi w specyficzne gusty jej członków. Przekonali się o tym nie tylko przedsiębiorcy z branży e-commerce, ale także członkowie sztabu wyborczego Donalda Trumpa. Zapraszamy Cię w świat mikrotargetowania.

Czym jest mikrotargetowanie?

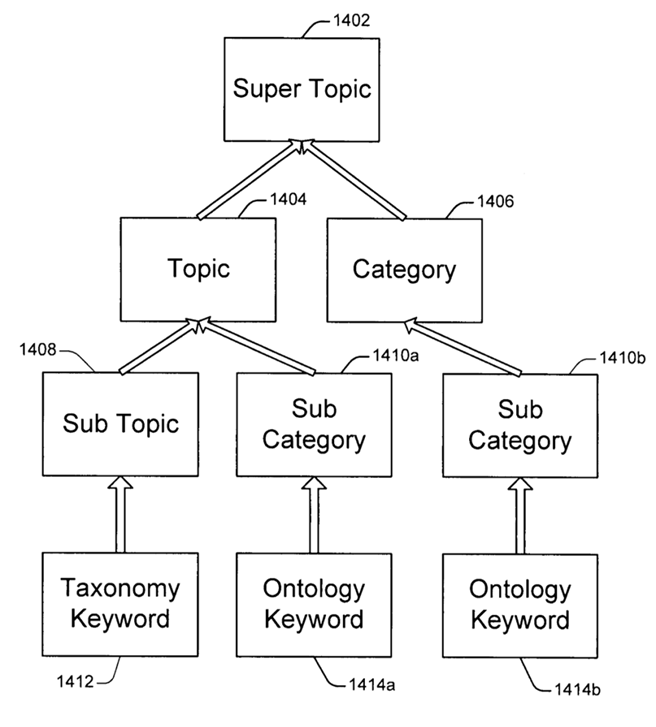

Mikrotargetowanie (nazywane także targetowaniem niszowym – z angielskiego niche targeting) to proces, który polega na dokładnej analizie i selekcjonowaniu konsumentów oraz dzieleniu ich na odpowiednie grupy. Określając grupy docelowe, bierze się pod uwagę między innymi zainteresowania odbiorców, ich oczekiwania, potrzeby i pragnienia, a także demografię. Analizie poddawane są także zachowania konsumenckie. Wszystko po to, aby stworzyć i skierować do nich specyficzny przekaz – taki, który wzbudzi ich maksymalne zainteresowanie.

Celem mikrotargetowania jest jak najdokładniejsza selekcja grupy docelowej, po to, aby przekaz reklamowy trafił wyłącznie (lub w znacznej większości) do osób potencjalnie zainteresowanych danym produktem lub usługą. Mikrotargetowanie stoi nieco w opozycji do kampanii ATL (above the line), których nośnikiem są mass media i które kierują ten sam komunikat do odbiorcy masowego. W mikrotargetowaniu chodzi o dopasowanie przekazów do niewielkich, precyzyjnie dobranych grup.

Wydawać by się mogło, że nie ma w tym nic zaskakującego i innowacyjnego. W praktyce jednak implementacja procesu mikrotargetowania do strategii marketingowej e-commerce jest jedną z najważniejszych dróg do podnoszenia pozycji danej strony w rankingach Google.

Mikrotargetowanie i Big Data, czyli jak poznać użytkowników internetu?

Mikrotargetowanie może być skuteczną formą marketingu i wywoływać reakcje w odbiorcach, szczególnie wtedy, gdy skupia się na analizie profili w mediach społecznościowych. Znajomość zainteresowań odbiorców i wiedza na temat ich potrzeb oraz pragnień może pomóc Ci dopasować przekaz w taki sposób, aby wywołał on określone reakcje. Jednak czy takie poznanie zachowań internautów jest możliwe? Owszem, jest. Aby to zrozumieć, należy przywołać termin, który wiąże się bezpośrednio z mikrotargetowaniem – pojęciem tym jest Big Data (więcej informacji na ten temat znajdziesz a artykule Systemy Big Data i Internet of Things).

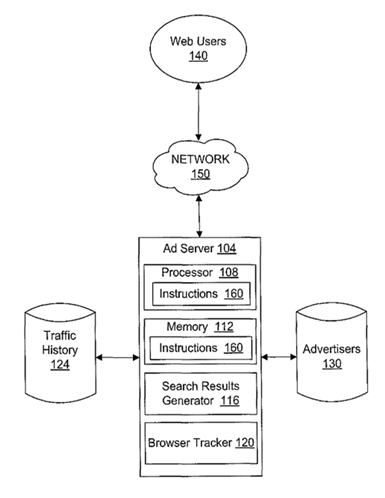

Termin Big Data odnosi się do różnorodnych, dużych i zmiennych zbiorów danych. Ich analiza i przetwarzanie często nie są łatwe, jednak mogą przynieść nową wiedzę i wymierne korzyści. Określenia Big Data używa się także w kontekście elektronicznych śladów, jakie zostawiasz za sobą w sieci. Może to być na przykład kliknięcie „wezmę udział” przy wydarzeniach na Facebooku, każdy „like”, zakupy z użyciem karty płatniczej, aplikacje, z których korzystasz, „meldowanie się” w różnych miejscach za pośrednictwem Facebooka czy zapytania, jakie wpisujesz w wyszukiwarkę. Na co dzień możesz pewnie zauważyć, że to, co wyszukujesz w Google i to, jakie strony odwiedzasz, ma odzwierciedlenie w reklamach, które widzisz w sieci. Na przykład – w popularnym sklepie internetowym szukasz butów trekkingowych, po czym opuszczasz stronę (niezależnie od tego, czy poszukiwania okazały się udane, czy też nie). Co się dzieje potem? Przez najbliższe dni obserwujesz, zarówno na portalach społecznościowych, jak i innych stronach, które odwiedzasz, że większość reklam dotyczy właśnie butów i akcesoriów trekkingowych.

Jak widać, Twoja aktywność w sieci pozostawia ślady, które są skrupulatnie zbierane i analizowane, a potem wykorzystywane na przykład w celach komercyjnych. O tym, co i w jaki sposób można wyczytać na podstawie aktywności w sieci, dowiesz się już za chwilę.

Jakie techniki wykorzystuje się do analizy osobowości internautów?

Istnieją pewne zaawansowane techniki, służące do analizy zachowań i osobowości użytkowników internetu, na czele z użytkownikami mediów społecznościowych. Dwie najbardziej znane metody to OCEAN oraz IBM.

MODEL OCEAN

Został opracowany na początku lat 80. Zgodnie z jego założeniami charakter konkretnej osoby można określić (zmierzyć) przy pomocy pięciu wymiarów osobowości:

- otwartości (openess),

- sumienności (conscientiousness),

- ekstrawersji (extroversion),

- zgodności (agreeableness),

- neurotyczności (neuroticism).

Pozyskanie i analiza takich danych mogą dać odpowiedź na pytania dotyczące osobowości, potrzeb i pragnień danej osoby, a także przewidzieć jej zachowania. Niegdyś kłopot stwarzała jednak konieczność wypełniania długiej ankiety w celu zdobycia wartościowych informacji.

Problem został rozwiązany przez psychologa Michała Kosińskiego, studenta i pracownika Centrum Psychometrii w Laboratorium Cavendish uniwersytetu Cambridge. W początkowych etapach badań Kosiński stworzył aplikację dla Facebooka – użytkownicy brali udział w quizie, odpowiadali na pytania dotyczące ich charakteru i zachowania, a na koniec otrzymywali swój model osobowości. Naukowcy z Cambridge natomiast – informacje niezbędne do analizy. Popularność aplikacji była ogromna – swoje dane udostępniły miliony ludzi.

Po obliczeniu wartości OCEAN dla danego użytkownika Michał Kosiński i jego współpracownicy porównywali wynik z aktywnością w sieci danej osoby – co polubiła, co udostępniła na Facebooku, jaką wpisała płeć, jaki wiek, miejsce zamieszkania, edukację itp. Wnioski, jakie wyciągnięto, były zaskakujące. Według Kosińskiego na podstawie 68 polubień na Facebooku można określić np. kolor skóry danego użytkownika, jego orientację seksualną, upodobania polityczne, stosunek do religii, alkoholu, papierosów, narkotyków, stopień inteligencji, a także to, czy jego rodzice do 21. roku życia tej osoby pozostawały w związku, czy też nie. Im więcej razy dana osoba kliknie „like”, tym lepiej da się przewidzieć jej zachowanie. Do tej szczegółowej analizy bierze się pod uwagę także zdjęcia oraz ilość kontaktów, a nawet czujnik ruchu w telefonie (nawet gdy telefon jest offline).

Wykorzystując model OCEAN i analizę aktywności użytkowników internetu można nie tylko przeanalizować dane badanych osób, ale także szukać określonych typów osobowości.

METODA IBM

Metoda ta zwana jest także analizą predykcyjną. Polega na analizie istniejących danych, wyciąganiu z nich wniosków oraz wydobywaniu informacji. Celem jest oczywiście przewidywanie nadchodzących zdarzeń i trendów oraz określanie wzorów zachowań konsumentów.

W analizie predykcyjnej analizuje się niewielką grupę osób, które już skorzystały z Twoich usług lub kupiły Twoje produkty. Na tej podstawie buduje się tak zwany model predykcyjny, który pomaga zidentyfikować zbiór cech wspólnych dla wielu użytkowników. Takimi cechami mogą być np.: wysokość odchodów, miejsce zamieszkania, stan cywilny, liczba dzieci, a nawet konkretne zainteresowania. Istotne jest to, aby wydobyć wyjątkowe cechy, łączące osoby z jednej grupy.

Dane, na podstawie których dokonasz analizy predykcyjnej to np. historia zamówień Twoich klientów czy odpowiedzi na pytania zamieszczone w ankiecie. Istnieje też możliwość zakupu danych konsumenckich i demograficznych – zbieraniem takich informacji zajmują się wyspecjalizowane firmy.

Na podstawie analizy osób, które już skorzystały z Twoich usług, możesz oszacować, jakie charakterystyczne cechy posiadają Twoi klienci i jak budować przekazy reklamowe, które będą odpowiedzią na te cechy.

Przygotowując się do analizy predykcyjnej, możesz zadać sobie kilka pytań, które pomogą Ci określić kierunki działań:

- Kto jest moim dotychczasowym klientem?

- Co mają ze sobą wspólnego moi klienci?

- Które inne osoby mają takie same cechy, co dotychczasowi klienci?

- Jak dotrzeć do nowych klientów?

- Jak rozszerzyć bazę klientów, znając ich specyficzne upodobania?

Czy mikrotargetowanie ma związek z sukcesem wyborczym Donalda Trumpa?

Dane pozyskane na podstawie analiz zachowań internautów nie są wykorzystywane wyłącznie w branży e-commerce. O skuteczności mikrotargetowania można przekonać się, analizując przebieg kampanii i wyniki wyborów prezydenckich w Stanach Zjednoczonych z 2016 roku. Sukces wyborczy Donalda Trumpa, według przypuszczeń wielu badaczy, jest oparty w dużej mierze właśnie na mikrotargetowaniu wyborców.

Pod koniec 2014 roku sztab wyborczy Donalda Trumpa zatrudnił firmę Cambridge Analytica, która, w największym uproszczeniu, zajmuje się analizą danych. Michał Kosiński (odpowiedzialny za wdrożenie modelu OCEAN i analizę zachowania internautów), jak sam twierdzi, nie ma nic wspólnego z działaniami tego przedsiębiorstwa. Nie da się jednak ukryć, że firma w dużej mierze oparła swoje działania na wynikach doświadczeń polskiego psychologa.

Przedstawiciele firmy twierdzili, że nie można odnieść sukcesu, planując kampanię wyborczą tylko na podstawie danych demograficznych. Podział społeczeństwa na jednolite grupy i wysyłanie takiego samego przekazu do wszystkich kobiet, tylko dlatego, że mają taką samą płeć, czy do Afroamerykanów, ponieważ łączy ich kolor skóry, jest bezsensowny.

Podczas jednego z wystąpień, założyciel Cambridge Analityca, Alexander Nix, oznajmił, że jego firma opracowała system, który może obliczyć, jaką osobowość ma każdy dorosły obywatel USA. Wykorzystuje się do tego psychologiczną analizę behawioralną na podstawie modelu OCEAN, analizę Big Data i reklamę celową (dopasowującą się do jak najbardziej do charakteru konsumentów).

Ponieważ w USA większość danych osobowych jest na sprzedaż, firma Cambridge Analityca kupiła wszystko, co było możliwe – listy wyborców, wypisy z ksiąg wieczystych, listy członków organizacji, dane medyczne czy subskrypcje czasopism. Dane te porównano z Big Data internautów (np. polubieniami na Facebooku) i obliczono model OCEAN. Wyniki analizy pozwoliły na określenie osobowości wyborców, ich realnych pragnień, potrzeb i obaw.

Dzięki takiej wiedzy komunikaty wyborcze Trumpa mogły trafiać w sedno upodobań różnych grup wyborców. Mówi się, że między innymi tym należy tłumaczyć sprzeczności pojawiające się w wypowiedziach obecnego prezydenta USA.

W trzecim dniu prezydenckiej debaty Trump-Clinton, sztab Trumpa wysłał 175 000 komunikatów (głównie za pośrednictwem Facebooka). Różniły się one minimalnie – tytułami, kolorami, śródtytułami, filmami czy zdjęciami. Wszystko po to, aby jak najbardziej dopasować przekaz do odbiorcy.

Te zaskakujące informacje mogą wydać się nieprawdopodobne i z pewnością nikt nie może w 100% potwierdzić, że firma Cambridge Analityca jest odpowiedzialna za wygraną Donalda Trumpa. Daje to jednak pole do własnej analizy i interpretacji – jak kandydat, którego pozycja w sondażach nie była najwyższa, zdobył poparcie Amerykanów i stał się prezydentem Stanów Zjednoczonych.

Mikrotargetowanie jest zagadnieniem niezwykle interesującym i obszernym. Wyniki wyborów prezydenckich w Stanach Zjednoczonych mogą tylko potwierdzać skuteczność tej metody. W kolejnych wpisach poznasz praktyczne wskazówki na temat mikrotargetowania w mediach społecznościowych, a także sposoby na wdrażanie analizy predykcyjnej w Twojej firmie.